Dernières publications

Study carried out by the Quantitative Practice Special thanks to Mouad JALLOULI.

NOS PUBLICATIONS

Dernières publications

Vanilla Deep Hedging

Vanilla Deep HedgingStudy carried out by the Quantitative Practice Special thanks to Mouad JALLOULI.

Machine learning methods for option pricing and model calibration

Machine learning methods for option pricing and model calibration Towards reducing experimental microscopy costs in live cell imaging using deep learning strategies

Towards reducing experimental microscopy costs in live cell imaging using deep learning strategies Why And How To Use Ensemble Methods in Financial Machine Learning

Why And How To Use Ensemble Methods in Financial Machine Learning#BLOGPOSTS

La volatilité comme transmetteur du risque systémique

La volatilité comme transmetteur du risque systémiqueAu sein des marchés financiers, la valeur des actions est constamment influencée par de nombreux facteurs.L’objectif principal des banques et des fonds d’investissement est de déterminer ces facteurs afin d’anticiperau maximum les trajectoires possibles des marchés. Suite

Les facteurs de risque non modélisables (NMRF) dans la nouvelle réglementation bâle 4 et leur impact sur les fonds propres des banques

Les facteurs de risque non modélisables (NMRF) dans la nouvelle réglementation bâle 4 et leur impact sur les fonds propres des banquesLa revue fondamentale du trading book, aussi appelée Bâle IV, est une proposition de réglementation bancaire. Publiée initialement en 2016 par le comité de Bâle et mise à jour en 2019, elle vise à renforcer davantage le cadre réglementaire existant et définit des nouvelles modalités de calcul des exigences en fonds propres.

Quels sont les impacts de la taxonomie européenne pour une économie plus verte ?

Quels sont les impacts de la taxonomie européenne pour une économie plus verte ?La taxonomie a identifié six objectifs environnementaux. Ils reflètent les principaux défis environnementaux auxquels l’Union Européenne est confrontée.

Les secrets de la Titrisation

Les secrets de la TitrisationAccusée d’être un contributeur principal à la crise financière de 2008, la titrisation reste assez présente dans le marché financier. On constate, à part les structures classiques, des montages financiers innovants et de nouvelles initiatives qui cherchent à aligner la titrisation aux nouvelles réglementations et contraintes du marché.

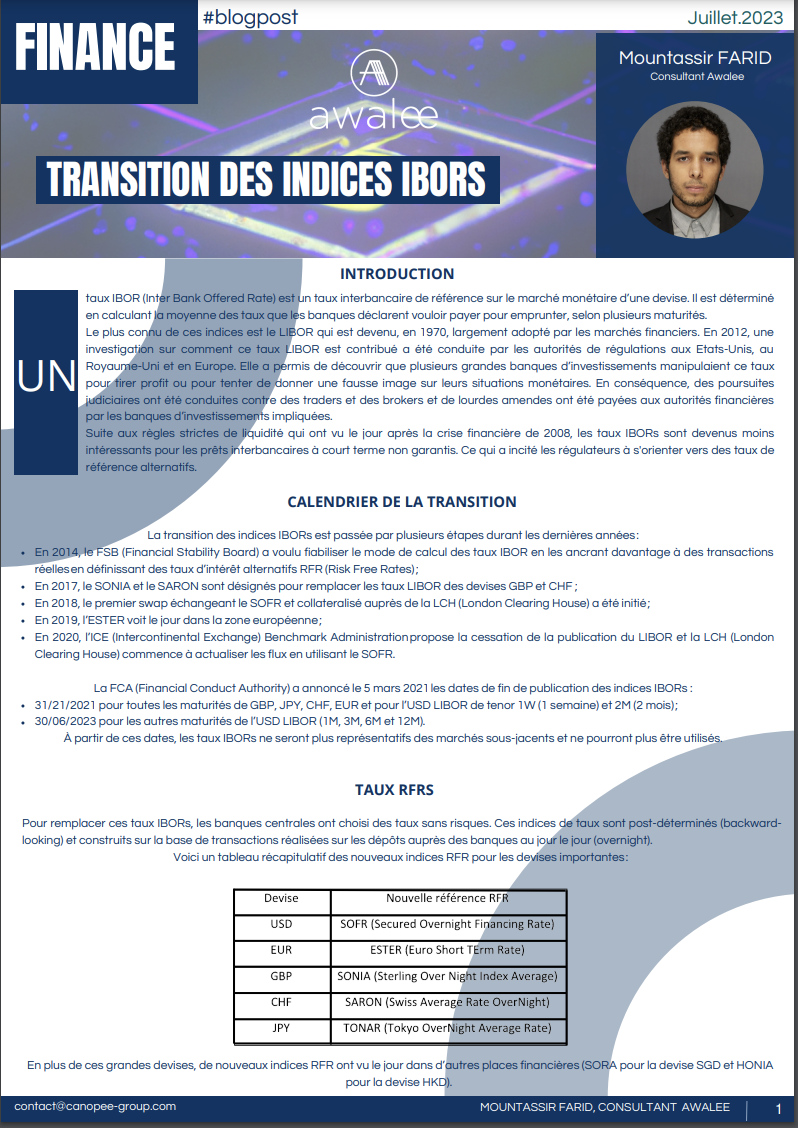

Au sein des marchés financiers, la valeur des actions est constamment influencée par de nombreux facteurs.L’objectif principal des banques et des fonds d’investissement est de déterminer ces facteurs afin d’anticiperau maximum les trajectoires possibles des marchés. Suite La revue fondamentale du trading book, aussi appelée Bâle IV, est une proposition de réglementation bancaire. Publiée initialement en 2016 par le comité de Bâle et mise à jour en 2019, elle vise à renforcer davantage le cadre réglementaire existant et définit des nouvelles modalités de calcul des exigences en fonds propres. Study carried out by the Quantitative Practice Special thanks to Mouad JALLOULI. La taxonomie a identifié six objectifs environnementaux. Ils reflètent les principaux défis environnementaux auxquels l’Union Européenne est confrontée. Accusée d’être un contributeur principal à la crise financière de 2008, la titrisation reste assez présente dans le marché financier. On constate, à part les structures classiques, des montages financiers innovants et de nouvelles initiatives qui cherchent à aligner la titrisation aux nouvelles réglementations et contraintes du marché. Un taux IBOR (Inter Bank Offered Rate) est un taux interbancaire de référence sur le marché monétaire d’une devise. Il est déterminé en calculant la moyenne des taux que les banques déclarent vouloir payer pour emprunter, selon plusieurs maturités. Study carried out by the Quantitative Practice Special thanks to Baptiste Chantry La finance quantique est un nouveau domaine qui a émergé de la convergence de deux domaines : la finance et la physique quantique. La physique quantique est une branche de la physique qui étudie le comportement des particules subatomiques, et elle a récemment été appliquée à la finance pour améliorer les stratégies d’investissement. La transformation numérique a apporté une profonde mutation au secteur de la finance. Commençant d’abord par les La transformation numérique a apporté une profonde mutation au secteur de la finance. Commençant d’abord par les Study carried out by the Quantitative Practice Special thanks to Hamza ANDAM.

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

NOS PUBLICATIONS

systèmes de paiements, elle s’est rapidement développée dans différentes formes d’investissements.

NOS PUBLICATIONS

systèmes de paiements, elle s’est rapidement développée dans différentes formes d’investissements.

NOS PUBLICATIONS

NOS PUBLICATIONS